Ein Analog-Digital-Wandler (auch A/D-Umsetzer[ADU] oder englisch Analog to Digital Converter [ADC]) wandelt ein analoges Signal (eine elektrische Spannung) in ein digitales Signal, also eine binauml;re Zahlenfolge um.

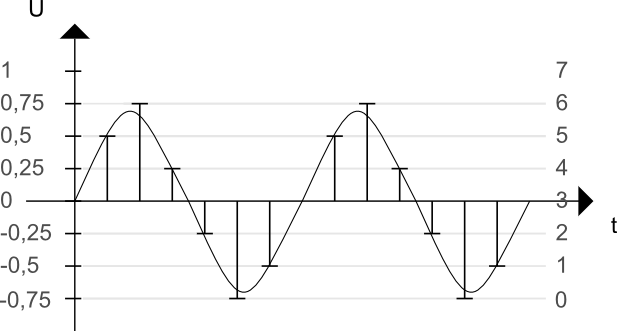

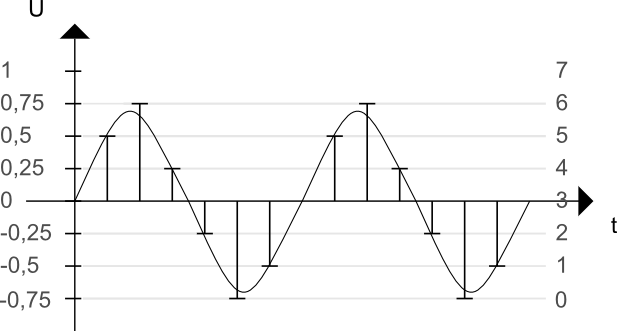

Grundprinzip: Ein analoges Signal wird mit einer bestimmten Frequenz (z.B. 44100 mal pro Sekunde) abgetastet.

In der Abbildung kommt ein primitiver 3-Bit Wandler zum Einsatz — 3 Bit heißt es existieren 3 Zustände welche jeweils die Werte 0 oder 1 annehmen können, z.B. 001 , 101 oder 100 usw. Hieraus ergeben sich also 2³ = 8 verschiedene Kombinationsmöglichkeiten, sodass ein 3-Bit Wandler eine Spannung in 8 digitale Werte übersetzen kann.

Dabei kann es zu Rundungsfehlern kommen: z.B. wird dann aus dem Wert 0.445V digital der Wert 0.5V, ähnlich also wie beim Auf- und Abrunden in der Mathematik.

Im obigen Beispiel wird das Intervall [-1V;+1V] in 8 verschiedene (gleich große) Intervalle zerlegt: Ein Wert aus

[-1;-0,75] erhält den digitalen Wert 000,

[-0,75;-0,5] den digitalen Wert 001,

[-0,5;-0,25] den Wert 010 usw.

Je größer die Anzahl der Bits, desto feiner sind die Abstufungen. Ein 16bit-Wandler kann so ein Signal in 216=65636 verschiedene Stufen einteilen.

Bei Audio-CDs verwendet man eine Abtastrate von 44,1 kHz (also 44100-mal pro Sekude) und eine Wortbreite von 16 bit.

Das Nyquist-Shannon-Abtasttheorem besagt, dass bei der Abtastung die Abtastfrequenz mindestens doppelt so hoch

wie die maximale aufkommende Frequenz im Signal gewählt werden muss.

Man könnte also bei CDs maximal eine Frequenz von 21,05 kHz abtasten. Der übliche Frequenzgang für HiFi von 50 - 20000 Hz kann demnach abgetastet werden.

Der Vorteil der Digitalisierung liegt darin, dass nur noch die bits, die aus Null oder Eins bestehen, übertragen werden müssen. Das reduziert die Fehleranfälligkeit, weil ein Empfänger gut nur zwischen 2 Stufen unterscheiden kann.

Nachteil: Die Daten (z.B. Text eines Buches oder ein Buch) liegen nicht mehr direkt für uns interpretierbar vor, sondern benötigen ein Decodierprogramm (z.B. Computer). Gibt es diese Programme nicht mehr, sind die Daten wertlos, weil sie nicht mehr lesbar sind.

Fehlerkorrektur:

Um Fehler bei der Übertragung von Daten aufzuspüren, gibt es verschiedene (mehr oder weniger ausgeklügelte) Verfahren. Ein einfaches Verfahren ist die Verwendung eines Prüfbits.

Ein prominentes Beispiel ist der ASCII (American Standard Code for Information Interchange)-Code, der für die Darstellung von Zeichen (z.B. Buchstaben, Ziffern, Sonderzeichen) entwickelt wurde. Er war ursprünglich ein 7bit-Code, d.h. es konnten damit 27=128 Zeichen codiert werden. Ein Byte umfasst aber 8 bit. Das 8.bit war ein sogenanntes Prüfbit: es war 0, falls die Anzahl der Einsen gerade war, sonst 1. Beispiel: 10110001 oder 01111110.

Damit lässt sich erkennen, ob ein Byte richtig übertragen wurde. Falls zwei bits fehlerhaft sind, wird der Fehler nicht erkannt. Wird jedoch ein Fehler erkannt, kann die Übertragung des bits wiederholt werden. Deshalb bricht bei schlechter Übertragungsqualität die Datenrate zusammen, denn es müssen oft Datenpakete wiederholt gesendet werden (z.B. Wlan etc.).

Auwändigere Verfahren ermöglichen eine automatische Korrektur bei fehlerhaften Übertragungen.

Der Nachteil liegt aber in der erhöhten Anzahl an Kontrollbits.

Ein einfaches Beispiel:

| 1 | 1 | 0 | 1 | 0 | 1 | 0 | 0 |

| 1 | 1 | 0 | 1 | 1 | 1 | 1 | 1 |

| 1 | 0 | 0 | 0 | 1 | 0 | 1 | 1 |

| 1 | 0 | 0 | 1 | 0 | 0 | 0 | 0 |

Die Prüfbits werden so gesetzt, dass eine gerade Anzahl an Einsen (parity) sowohl in der Zeile als auch Spalte vorhanden sind.

Die schwarzen bits enthalten die Informationen.

Die grünen bits sind Prüfbits. Wird ein bit fehlerhaft übertragen (rotes bit in der 2.Zeile und 4. Spalte), dann

sind sowohl das Prüfbit in der 2 Zeile als auch das Prüfbit in der 4. Zeile falsch codiert. Daraus lässt sich das fehlerhafte bit lokalisieren und korrigieren.

Ist hingegen ein Prüfbit falsch, gibt es kein weiteres falsch codiertes Prüfbit.